|

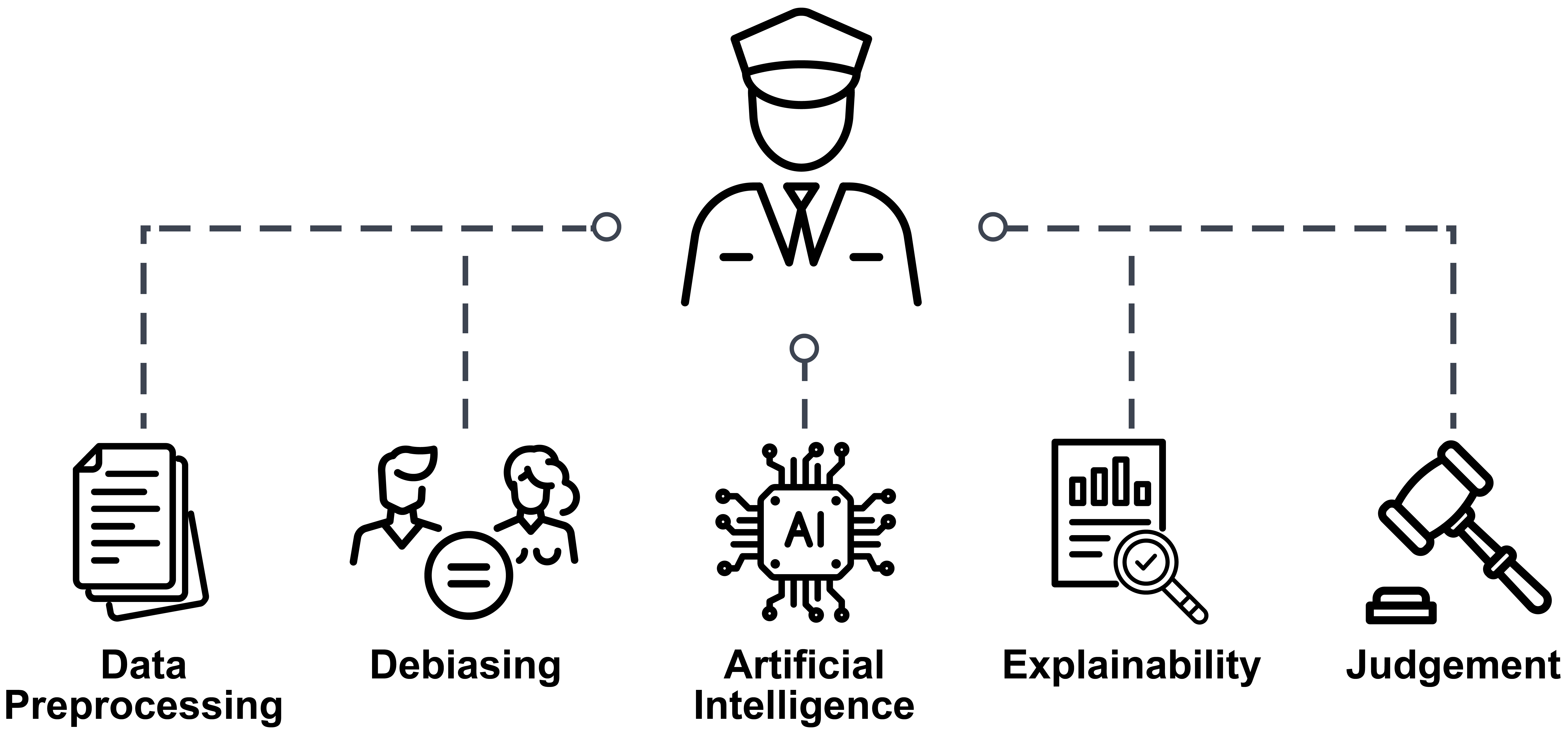

Für die Polizeiarbeit sind Texte aus verschiedenen Quellen, wie z. B. sozialen Medien, Online-Chats oder Handelsplattformen relevant. Dabei werden Texte, wie Posts, Kommentare, Chats, Anzeigen, Artikel oder interne Berichte untersucht, die sich in vielerlei Hinsicht stark unterscheiden. Infolgedessen sollen mehrere Datensätze erstellt werden, die polizeiliche Szenarien abbilden. Diese Datensätze dienen als Grundlage für das Training von später zu erklärenden Modellen. Gleichzeitig sollen die Datensätze als Referenz verwendet werden, um die Ergebnisqualität und Performanz von Basismodellen mit den erklärbaren Modellen zu vergleichen.

Da KI-Modelle anhand von Trainingsdaten erlernen, spezielle Aufgaben zu lösen, ist die Qualität der Daten ausschlaggebend für die Ergebnisqualität der Modelle. Befinden sich in den Daten beispielsweise überwiegend Personen einer Herkunft, einer Altersgruppe oder eines Geschlechts, so entsteht eine kognitive Verzerrung (Bias), die diese Personengruppen womöglich benachteiligt. Um dies zu verhindern sind ausgewogene Trainingsdaten notwendig. In dem Falle, dass diese nicht vorhanden sind, können Methoden zum Debiasing eingesetzt werden, die in diesem Projekt untersucht, entwickelt und evaluiert werden.

Weiterhin werden Lösungen zur Erstellung von Erklärungen getroffener Entscheidungen von KI-Modellen entwickelt. Zum Einsatz können dabei automatisierte Markierungen relevanter Textbausteine, wie Personen, Zeitpunkte, Orte und Gegenstände kommen. Auch lässt sich visualisieren, wie stark spezifische Wörter die Entscheidungen eines Modells beeinflussen. Neben der Erklärung von Modellen und Algorithmen können so auch erläuternde Kommentare zu einer Auswertung erstellt werden, die etwa bei Ermittlungen zu Volksverhetzung Anwendung finden.

Die in diesem Teilprojekt entwickelten Methoden, Modelle und Algorithmen sollen schließlich in einen Demonstrator integriert werden, der von mehreren Parteien des Gesamtverbunds gemeinsam entwickelt wird. Die polizeilichen Anwenderinnen und Anwender (u. a. das Polizeipräsidium München, die Landeskriminalämter Baden-Württemberg und Nordrhein-Westfalen sowie das Bundeskriminalamt) können dann mit Modellen und Erklärungen experimentieren, sodass zunächst eine Optimierung der verwendeten Methoden und Darstellungen möglich ist, bevor die Applikation eingesetzt wird.

Über den gesamten Verlauf des Projekts finden Aktivitäten zur Prüfung der Übertragbarkeit und zur Standardisierung statt. Die entwickelten Lösungen zur Erklärbarkeit, zum Debiasing und zur Robustheit von Modellen werden mit den anderen Projektpartnern aus den Bereichen der Gesichtserkennung, der Sprechererkennung und der Objektdetektion geteilt, um potenzielle Übertragbarkeiten zu erkennen und umzusetzen. Die Standardisierungsaktivitäten werden in Kooperation mit dem Deutschen Institut für Normung e. V. (DIN) durchgeführt, um Standardisierungsbedarfe zu erkennen und Standardisierungsaktivitäten im Hinblick auf die genannten Aspekte auf europäischer und internationaler Ebene durchzuführen.

|

|

An dem Gesamtvorhaben VIKING sind insgesamt zehn Verbund- sowie drei assoziierte Partnerinnen und Partner beteiligt. Neben den bereits namentlich erwähnten polizeilichen Anwendern und dem DIN arbeiten die Zentrale Stelle für Informationstechnik im Sicherheitsbereich, das Bundesamt für Sicherheit in der Informationstechnik, das Fraunhofer Institut für digitale Medientechnologie, die Hochschule für Wirtschaft und Recht Berlin, die IDEMIA Identity & Security Germany AG, die Universitäten Konstanz und Tübingen gemeinsam mit der Universität der Bundeswehr München zusammen.

Projektumriss VIKING (PDF, 140KB)

|

|

Gefördert durch:

|